7 Cara Optimasi Crawl Budget untuk Meningkatkan SEO Anda

- Tips dan Trick

- 16 Agt 2024

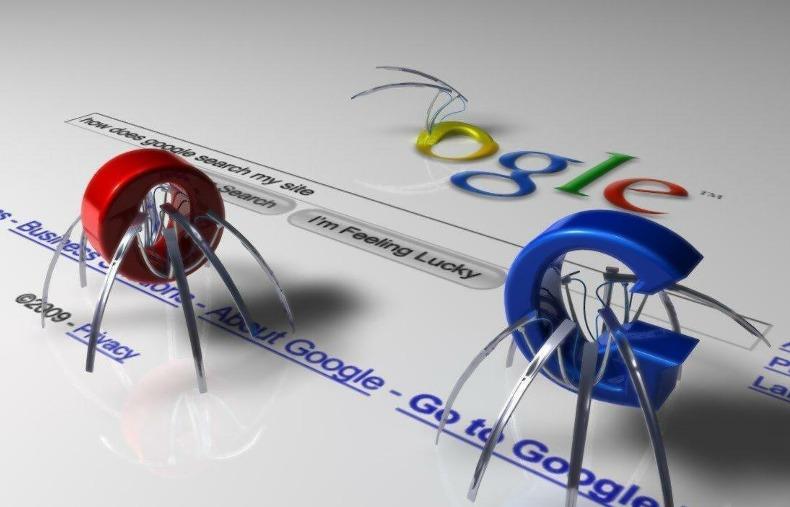

Mungkin diantara Anda pemilik website penasaran, bagaimana caranya agar Google menyukai dan mengindeks website Anda? Rahasianya sangat sederhana, arahkan crawler atau bot hanya ke halaman penting dan berguna di website Anda. Tentunya Anda ingin Google atau Bing mengindeks setiap URL yang ada pada website, namun bagaimana dengan halaman berkualitas rendah dan tidak relevan? Anda dapat mencegah crawler untuk menjelajahi halaman tersebut dengan menggunakan “Crawl Budget”.

Apa Itu “Crawl Budget”?

Ketika Googlebot (atau BingBot) menjelajahi website Anda, ia hanya memiliki jumlah yang terbatas untuk mengakses halaman. Dengan kata lain, crawl budget adalah jumlah halaman (URL) yang akan dijelajahi Google pada suatu website. Jumlah ini bervariasi dari hari ke hari, tetapi secara keseluruhan relatif stabil. Jumlah yang dijelajahi umumnya ditentukan oleh nilai atau kualitas website (berapa banyak Google menemukan kesalahan), termasuk kualitas link balik (backlink) ke website Anda.

Google tidak selalu menjelajah ke setiap halaman seketika itu juga, bahkan bisa jadi setiap minggu. Kadang-kadang hanya menjelajah 6 halaman, atau 5000, bahkan 100.000 halaman tergantung pada banyak faktor. Hal ini adalah salah satu usaha untuk meningkatkan SEO Anda.

Mengapa Anda Harus Memperhatikan Hal Ini?

Berikut adalah beberapa manfaat ketika Anda mengontrol akses sebuah crawler:

Memberi Prioritas Ke Halaman Yang Penting

Ketika Anda mengatur akses ke halaman mana saja Googlebot diperbolehkan untuk menjelajah, ini akan meningkatkan kemungkinan bahwa halaman penting dan halaman “andalan” akan dijelajahi setiap kali Googlebot mengunjungi website Anda.

Contohnya adalah laman produk atau blog, halaman ini ingin memiliki peringkat tinggi dalam hasil pencarian, sehingga pengguna dapat menemukan informasi dengan cepat.

Mengabaikan Halaman Yang Tidak Perlu Peringkat

Selalu ada laman website yang tidak perlu diindeks dalam hasil pencarian. Ini adalah sebuah tempat di mana pengguna biasanya tidak mencari informasi yang mendalam tapi mungkin akan browse sementara ke halaman tersebut.

Bagaimana Cara Membantu Googlebot Mengakses Halaman Yang Tepat?

Ada banyak cara untuk membantu Googlebot atau BingBot mengakses website. Anda dapat menyesuaikan atau menerapkan beberapa cara berikut:

1. Robots.txt File

Hal pertama yang harus diperhatikan adalah pengaturan hal apa saja yang dilarang pada file robots.txt. Dengan kata lain, tipe folder atau file di website Anda yang tidak perlu untuk dijelajahi. Ketika mengunjungi website, tempat pertama yang dilihat oleh crawler adalah file robots.txt Anda (dengan syarat file tersebut berada di www.domain.com/robots.txt). Ini akan membantu menunjukkan kepada crawler URL mana saja yang tidak boleh dijelajahi. Anda dapat menetapkan aturan untuk crawler bagian mana saja yang ingin dijelajahi pada website.

Jika sudah menerapkan cara ini, jangan lupa untuk selalu menguji aturan Anda menggunakan alat pengecek robot.txt Google Search Console untuk memastikan aturan yang Anda buat dapat berjalan dengan baik. Karena beberapa aturan yang salah dapat memblokir seluruh situs atau URL yang tidak ingin diblokir.

2. Noindex Tags

Untuk mencegah URL tertentu diindeks oleh Google, cara ini dapat membantu Anda. Tambahkan tag noindex dikode header halaman tersebut. Setelah ditambahkan, uji kembali tag ini dengan melakukan Fetch as Google sebagai permintaan URL untuk diindeks di Google Search Console.

3. URL Parameter Rules

Jika website Anda menggunakan CMS (Content Management System) atau sistem e-commerce, Anda harus berhati-hati karena URL yang dihasilkan secara dinamis menyebabkan duplikasi halaman. Googlebot dapat dengan mudah terjebak dan membuang waktu untuk menjelajahi URL ini.

Anda dapat menggunakan URL Parameter di Google Search Console untuk membantu membedakan URL dinamis yang ditemukan oleh Google. Namun untuk menggunakan alat ini, Anda harus berhati-hati karena jika salah mengonfigurasi dapat mengakibatkan URL tidak dapat diindeks oleh Google.

4. Up-to-date XML Sitemaps

Meskipun Google tidak mengambil sitemap XML Anda sebagai aturan dalam penjelajahan crawler, namun ini akan sangat dibutuhkan sebagai petunjuk. Jadi pastikan sitemap XML Anda up to date (yang terbaru), sehingga membantu memperkuat halaman mana yang seharusnya diindeks. Hapus URL lama Anda (atau halaman yang tidak dibutuhkan) dan tambahkan dengan URL baru.

5. Fix Internal Links

Googlebot akan menjelajahi link yang ditemukan dalam konten website, jadi pastikan Anda tidak membiarkan crawler untuk menjelajah ke halaman yang hilang (broken link). Gunakan alat bantu penjelajah seperti Screaming Frog’s SEO Spider Tool untuk menemukan link internal yang rusak, sehingga Anda dapat dengan mudah memperbaiki sumbernya.

6. Page Load Times

Ketika melakukan kunjungan, Googlebot selalu memuat setiap halaman yang ada. Dengan mengurangi ”load time” pada website, ini memungkinkan crawler untuk menjelajah dan mengindeks halaman lain dalam rata-rata waktu yang sama.

7. Site Structure

Struktur situs yang baik adalah metode untuk membantu crawler menjelajahi situs Anda jauh lebih mudah. Dengan pengkategorian konten yang jelas serta tidak menyembunyikan halaman terlalu dalam pada struktur situs, ini dapat meningkatkan kemungkinan halaman tersebut akan ditemukan oleh Googlebot.

Lalu, Apa Keuntungannya Untuk SEO?

Apabila Anda sudah berhasil menerapkan beberapa atau semua metode di atas dan diuji dengan alat yang sudah disebutkan, maka Anda akan melihat beberapa perubahan dalam statistik crawl yang tertera di Google Search Console. Sehingga bisa lebih mudah memeriksa “kesehatan” website Anda.

Jika Google sering menjelajah halaman “andalan” Anda, peringkat dari halaman tersebut mungkin akan lebih baik. Konten yang baru dan “segar” akan cepat terindeks dan akan mendapatkan peringkat jauh lebih cepat serta tidak akan membuang waktu dari “crawl budget” Anda.